در یادگیری ماشین، مدلهای زبانی بزرگ (LLM) مانند GPT-4 و Claude توانستهاند پاسخهای شبیه به انسان را از انبوهی از میلیاردها داده متنی تولید کنند. اما آیا میتوان قدرت پیشبینی مدلها را مؤثرتر از آموزش معمول بهبود بخشید؟ محققان مایکروسافت و دانشگاه پکن با یک راهحل جدید به نام پیشآموزش تقویتی (RPT) به این سوال پاسخ مثبت دادهاند.

RPT چیست؟ بازآفرینی آموزش مدل زبانی

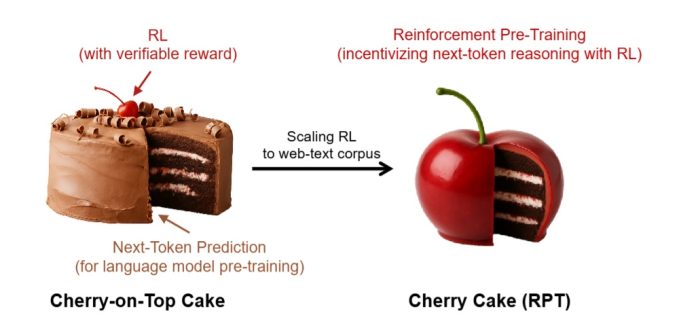

مدلهای زبانی در گذشته آموزش داده میشدند تا فقط توکن بعدی (کلمه یا نماد) را پیشبینی کنند. RPT این را به یک فرآیند استدلال تبدیل میکند. مدل به جای حدس زدن صرف، “فکر میکند”، فرضیه میسازد و سپس پیشبینی توکن بعدی را انجام میدهد.

این مدل با استفاده از یادگیری تقویتی با یک تغییر بزرگ آموزش داده میشود: پاداشها از خود دادههای متنی تولید میشوند، نه از انسانها یا مدلهای دیگر.

چرا RPT مهم است؟

پاداشهای بینقص و سخت: این روش در مواردی که پیشبینی تقریباً برابر یا نزدیک به دادههای واقعی باشد اما دقیقاً مطابق با آنها نباشد، پاداش نمیدهد، برخلاف مدلهای دیگری که میتوانند با کپی کردن یا شبیهسازی پاسخها، سیستم پاداش را فریب دهند یا دستکاری کنند.

مقیاسپذیری بالا: از همان دادههای متنی استاندارد (مثلاً کتابها یا ویکیپدیا) استفاده میکند، اما با تبدیل آنها به “مسائل استدلالی” کیفیت آموزش را بهبود میبخشد.

عملکرد پیشبینی بهبود یافته: مدل RPT-14B ممکن است در آزمایشها از مدلهای قدرتمندتر و بزرگتری مانند R1-Qwen-32B بهتر عمل کند.

صلاحیت پاسخ Zero-Shot بهبود یافته: به این معنی که مدل ممکن است به بسیاری از سؤالات مختلف پاسخ دهد، حتی زمانی که در حین آموزش شاهد مثال مشابهی نبوده است.

آزمایشهای کلیدی

محققان از مجموعه دادههای ریاضی OmniMATH و معیارهای سختی مانند MMLU-Pro و SuperGPQA برای آزمایش روش RPT استفاده کردند. عملکرد قابل توجه بود:

دقت پیشبینی توکن آن در دادههای سخت تا 3٪ بهتر از مدلهای پایه بود.

در آزمایشهای Zero-Shot، مدل RPT حتی تا ۲۲٪ از مدل پایه نوع ۳۲B پیشی گرفت.

چگونه تفکر RPT با روشهای معمول متفاوت است

یکی از جذابترین بخشهای مقاله ای که مبنای این مبحث بوده است، توضیح گرایشهای «تفکر مدل» RPT بود. به عنوان مثال، مدل RPT نه تنها فرضیهها را تدوین میکند، بلکه گرایشهای «بازنگری»، «استنتاج منطقی» و «تفکر واگرا» را نیز در متن خود نشان میدهد.

آینده RPT: فقط آغاز

اگرچه آزمایشهای اولیه موفقیتآمیز بودند، نویسندگان خاطرنشان میکنند که جای زیادی برای بهبود در RPT وجود دارد:

شامل دادههای متنی عمومیتر نسبت به دادههای ریاضی صرف

آزمایشهایی با اندازههای مدل بزرگتر

ادغام RPT با روشهای «استدلال ترکیبی»RPT در پایان باید بیان نمود که انقلابی در آموزش مدلهای زبان طبیعی ایجاد میکند. این روش با ورود به استدلال گام به گام در مراحل اولیه آموزش، مدلها را مجبور میکند تا عمیقتر درک کنند، نه فقط بهتر کپی کنند. اگر نگران آینده هوش مصنوعی هستید، RPT چیزی است که باید در نظر گرفته شود.

منبع: مقاله اصلی در arXiv با شناسه 2506.08007 منتشر شده است.